در دنیای اینترنت، مدیریت نحوه دسترسی رباتهای موتورهای جستجو به محتوای وبسایتها اهمیت زیادی دارد. یکی از ابزارهای مهم برای این کار، فایل robots.txt است. این فایل متنی ساده که در دایرکتوری اصلی سایت قرار میگیرد، به رباتهای جستجو میگوید که کدام بخشهای سایت را باید بررسی کنند و کدام یک را نادیده بگیرند. استفاده درست از این فایل میتواند به بهبود رتبه سایت در نتایج جستجو، کاهش بار روی سرور و بهبود تجربه کاربری کمک کند.

robots.txt به مدیران وبسایت این امکان را میدهد که بخشهایی از سایت را که نمیخواهند توسط موتورهای جستجو ایندکس شود، مسدود کنند. بهعنوان مثال، صفحات حاوی اطلاعات شخصی، دایرکتوریهای مدیریتی و صفحات موقت یا آزمایشی نباید توسط موتورهای جستجو دیده شوند. این کار نه تنها از نمایش محتوای غیرضروری در نتایج جستجو جلوگیری میکند، بلکه به موتورهای جستجو کمک میکند تا منابع خود را بر روی ایندکس کردن محتوای مهمتر متمرکز کنند.

در این مطلب، به بررسی جامع این فایل میپردازیم. ابتدا تعریف و هدف این فایل را توضیح میدهیم و سپس ساختار و قواعد نگارش آن را بررسی میکنیم. علاوه بر این، به اشتباهات رایج در نوشتن فایل و راهکارهای اصلاح آن خواهیم پرداخت. همچنین تاثیرات استفاده صحیح و نادرست از این فایل بر سئو و عملکرد وبسایت را مورد بحث قرار میدهیم و درنهایت، راهنماییهای کاربردی برای بهینه سازی فایل ربات txt ارائه خواهیم کرد. تا پایان این مطلب با آژانس دیجیتال مارکتینگ جینجر همراه باشید.

فایل robots.txt چیست؟

فایل ربات یک فایل متنی ساده است که در دایرکتوری اصلی (ریشه) وبسایت قرار میگیرد و به موتورهای جستجو و سایر رباتهای وب میگوید که کدام قسمتهای سایت را مورد بررسی (خزش) قرار دهد و به چه قسمتهایی نباید سر بزند. این فایل یکی از روشهایی است که میتواند دسترسی رباتها به وبسایت شما را مدیریت و کنترل کنند و به مدیران سایت کمک میکند تا کنترل بیشتری روی ایندکس گذاری و خزیدن رباتها داشته باشند.

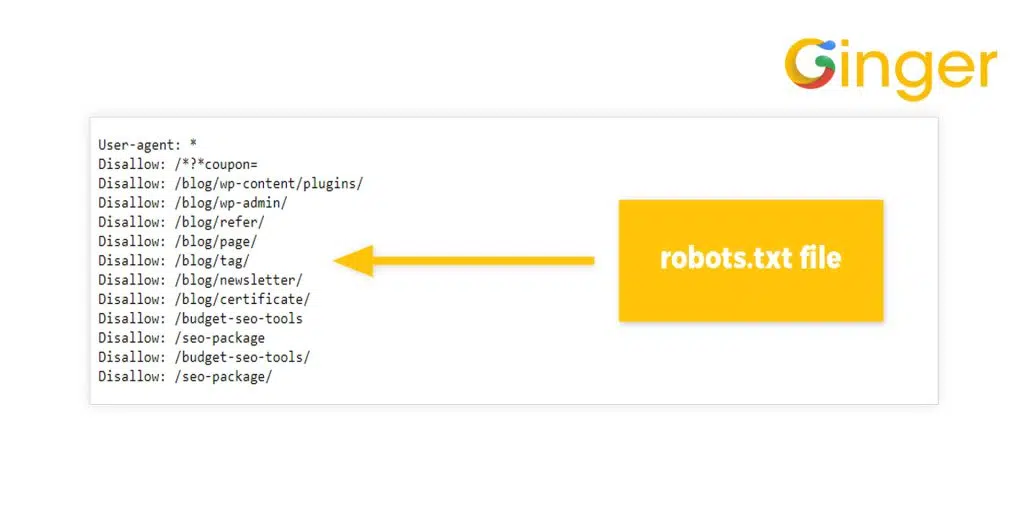

بهطور کلی robots.txt شامل دستورات ساده است که به رباتها میگوید کدام مسیرها و فایلها باید نادیده گرفته شوند (با استفاده از دستور Disallow) و کدام مسیرها اجازه دسترسی دارند (با استفاده از دستور Allow) و میتوانند توسط رباتهای جستجو مورد بررسی قرار گیرند. این فایل به ویژه برای بهینه سازی موتورهای جستجو و جلوگیری از دسترسی به بخشهای حساس یا غیرضروری وبسایت بسیار مفید است.

در واقع میتوان گفت این فایل یک ابزار ساده اما بسیار قدرتمند است که به مدیران وبسایت امکان میدهد تا دسترسی رباتهای وب به محتوی سایت خود را به دقت کنترل کنند. با استفاده از این فایل، میتوانند از نمایش اطلاعات حساس جلوگیری کنند، منابع سرور را بهینهتر مدیریت کنند و به بهبود رتبه سایت در نتایج موتورهای جستجو کمک کنند. به همین دلیل، داشتن یک فایل ربات بهینه و صحیح میتواند تاثیر بسیار زیادی بر عملکرد و بهینه سازی وبسایت داشته باشد.

هدف و کاربرد robots.txt چیست؟

robots.txt چیست؟ همانطور که گفته شد، فایل robots.txt با هدف مدیریت دسترسی رباتهای وب به بخشهای مختلف یک وبسایت ایجاد شده است. این فایل به مدیریت وبسایت امکان میدهد تا بهطور دقیق تعیین کنند که کدام صفحات و دایرکتوریها توسط رباتهای جستجو و سایر رباتها قابل دسترسی و بررسی باشند و کدام بخشها نباید خزیده شوند. این سطح از کنترل خزیدن صفحات به دلایل مختلفی اهمیتی دارد که در ادامه به آنها اشاره میکنیم.

-

مدیریت دسترسی به محتوای حساس

یکی از اهداف اصلی استفاده از فایل ربات txt جلوگیری از دسترسی رباتها به بخشهای حساس یا خصوصی سایت است. برای مثال، صفحات حاوی اطلاعات شخصی کاربران، دایرکتوریهای مدیریتی و بخشهای آزمایشی نباید توسط موتورهای جستجو ایندکس شوند. با استفاده از این ربات مدیران میتوانند مطمئن شوند که این بخشها از دید عموم مخفی باقی میمانند و فقط برای کاربران مجاز قابل دسترسی هستند.

-

بهینه سازی منابع سرور

رباتها میتوانند بار زیادی بر روی سرور وارد کنند، به خصوص اگر تعداد زیادی از صفحات سایت را بهطور مکرر بررسی کنند. با استفاده از این فایل، مدیران وبسایت میتوانند دسترسی رباتها به صفحات غیرضروری را محدود کنند و در نتیجه بار کاری سرور را کاهش دهند. این کار میتواند به بهبود سرعت و عملکرد سایت برای بازدیدکنندگان واقعی کمک کند و همچنین هزینههای مرتبط با منابع سرور را کاهش دهد. برای این بهینه سازی میتوانید از خدمات سئو سایت متخصصان بهره ببرید.

-

بهبود ایندکس گذاری

هدف دیگر فایل robots.txt بهبود کارایی فرآیند ایندکس گذاری توسط موتورهای جستجو است. با محدود کردن دسترسی رباتها به صفحاتی که ارزش محتوایی کمی دارند یا تکراری هستند، مدیران وبسایت میتوانند به موتورهای جستجو کمک کنند تا بر محتوای ارزشمندتر و مهمتر سایت تمرکز کنند. این امر میتواند به بهبود رتبهبندی سایت در نتایج جستجو کمک کند، زیرا موتورهای جستجو به صفحات باکیفیت و مرتبط توجه بیشتری خواهند داشت.

مقالات مرتبط:

-

جلوگیری از مشکلات محتوای تکراری

محتوای تکراری میتواند به یک مشکل جدی در بهینه سازی موتورهای جستجو تبدیل شود. با استفاده از فایل ربات، مدیران میتوانند با رباتها را از خزیدن و ایندکس کردن صفحات تکراری یا نسخههای مختلف یک صفحه منع کنند. این کار به جلوگیری از بروز مشکلات محتوای تکراری کمک میکند و در نتیجه میتواند به بهبود رتبه سایت در نتایج جستجو منجر شود.

-

کمک به رباتهای وب برای عملکرد بهتر

این ربات بهعنوان یک راهنمایی برای رباتهای وب عمل میکند و به آنها کمک میکند تا بهطور کارآمدتری در سایت خزش کنند. با تعیین مسیرهای مجاز و غیرمجاز، مدیران وبسایت میتوانند به رباتها کمک کنند تا به سرعت به محتوای ارزشمند دسترسی پیدا کنند و از خزیدن در صفحات غیرضروری یا بلااستفاده خودداری کنند. این کار نه تنها به بهبود تجربه کاربری برای بازدیدکنندگان واقعی کمک میکند بلکه به رباتها نیز اجازه میدهد تا منابع خود را بهینهتر استفاده کنند.

فایل Robots.txt در کجا قرار دارد؟

فایل robots.txt در بالاترین سطح ساختاری وبسایت شما قرار دارد. برای یافتن آن، به بخش FTP در کنترل پنل هاستینگ خود (مانند سی پنل یا دایرکت ادمین) مراجعه کرده و در دایرکتوری روت سایت به دنبال آن بگردید. پس از انجام این مراحل، میتوانید این فایل را در دایرکتوری public_html سایت خود بیابید. حجم این فایل بسیار ناچیز بوده و در اکثر موارد کمتر از چند صد بایت خواهد بود.

چگونه فایل Robots.txt را ایجاد کنیم؟

فهمیدیم robots.txt چیست و با توجه به ماهیت متنی robots.txt، ایجاد آن به سادگی با استفاده از یک ویرایشگر متن ساده مانند Notepad امکانپذیر است. در یک ویرایشگر متن ساده مانند Notepad، یک فایل متنی جدید ایجاد کرده و آن را با نام robots.txt ذخیره نمایید. سپس به بخش cPanel هاست خود مراجعه کرده و با ورود به دایرکتوری public_html، فایل ایجاد شده را در روت دایرکتوری آپلود کنید.

پس از ورود به دایرکتوری public_html، فایل robots.txt را با استفاده از قابلیت Drag and Drop به داخل این دایرکتوری منتقل نمایید. لازم به ذکر است که برای اعمال تغییرات بر روی این فایل، باید دسترسی کامل به آن داشته باشید. در ادامه با علم به اینکه میدانید سئو چیست، نحوه ساخت فایل ربات به همراه دستورات آن آورده شده است.

ساختار و قواعد نگارش فایل ربات

فایل robots.txt از چندین بخش کلیدی تشکیل شده است. بخش اول معمولا با دستور “user-agent” شروع میشود که مشخص میکند دستورالعملها برای کدام رباتها اعمال میشود. علامت ستاره (*) به معنای همه رباتها است. برای مثال:

User-agent: *

این دستورالعمل برای همه رباتها اعمال میشود. اگر بخواهیم دستورالعمل خاصی را فقط برای یک ربات خاص اعمال کنیم، باید نام آن ربات را به جای ستاره بنویسیم:

User-agent: Googlebot

بعد از مشخص کردن User-agent میتوانیم از دستور Disallow استفاده کنیم تا مسیرهایی که رباتها نباید به آنها دسترسی داشته باشند را تعیین کنیم. بهعنوان مثال:

Disallow: /admin/

Disallow: /private/

این دستورات به رباتها میگویند که از خزیدن در دایرکتوریهای admin و private خودداری کنند. اگر بخواهیم که به رباتها اجازه دسترسی به مسیر خاصی را بدهیم از دستور “Allow” استفاده میکنیم:

Allow: /public/

این دستور به رباتها اجازه میدهد به دایرکتوری “public“ دسترسی داشته باشند.

هر User-agent میتواند مجموعهای از دستورهای Disallow و Allow مخصوص به خود داشته باشد. برای مثال:

Useragent: *

Disallow: /private/

User-agent: Googlebot

Allow: /public/

Disallow: /admin/

همچنین میتوانیم از علامت $ برای تطبیق دقیق با انتهای URL استفاده کنیم، برای مثال:

User-agent: *

Disallow: /private&

این دستور به رباتها میگوید که از خزیدن URL هایی که به private ختم میشوند خودداری کنند.

علاوه بر این میتوان با استفاده از علامت # در این فایل توضیحاتی را اضافه کرد. این توضیحات توسط رباتها نادیده گرفته میشوند و فقط برای توضیح بیشتر کاربرد دارند.

اشتباهات رایج در نوشتن فایل های robots.txt و راهکارهای اصلاح آن

با درک اینکه robots.txt چیست، نوشتن آن به ظاهر ساده است، اما اشتباهات کوچک میتوانند تاثیرات بزرگی بر سئو و دسترسی به وبسایت داشته باشند. در اینجا برخی از اشتباهات رایج و راهکارهای اصلاح آنها آورده شده است:

-

مسدود کردن اشتباهی تمام سایت

قرار دادن یک خط “Disallow: /” بدون درک کامل از تاثیر آن میتواند بهطور کامل از ایندکس شدن سایت توسط موتورهای جستجو جلوگیری کند.

User-agent:*

Disallow: /

راهکار:

مطمئن شوید که فقط بخشهای خاصی از سایت که نمیخواهید ایندکس شوند را مسدود کردهاید. برای مثال:

User-agent:*

Disallow: /private/

Disallow: /tmp/

-

نادیده گرفتن فایلهای ضروری

مسدود کردن دسترسی به فایلهای CSS، JavaScript و سایر منابع ضروری میتواند باعث شود که سایت به درستی نمایش داده نشود.

User-agent:*

Disallow: /css/

Disallow: /js/

راهکار:

اجازه دهید رباتها به این فایلها دسترسی داشته باشند تا سایت شما به درستی ایندکس و نمایش داده شود.

User-agent:*

Allow: /css/

Allow: /js/

-

عدم استفاده از نقشه سایت (Sitemap)

فراموش کردن افزودن نقشه سایت به فایل ربات میتواند فرصت بهبود ایندکس گذاری را از بین ببرد.

راهکار:

اطمینان حاصل کنید که آدرس نقشه سایت خود را به فایل robots.txt اضافه کردهاید.

Sitemap: http://www.example.com/sitemap.xml

-

استفاده نادرست از حروف بزرگ و کوچک

اشتباه:

robots.txt به حروف بزرگ و کوچک حساس است و اشتباهات تایپی میتوانند منجر به مسدود نشدن یا مسدود شدن نادرست بخشهای سایت شوند.

User-agent:*

Disallow: /Private/

راهکار:

از یکسان بودن حروف بزرگ و کوچک اطمینان حاصل کنید.

User-agent:*

Disallow: /private/

-

عدم تست و اعتبارسنجی robots.txt

عدم تست robots.txt میتواند منجر به بروز خطاها و مشکلات دسترسی شود.

راهکار:

همیشه فایل ربات خود را با ابزارهایی مانند Google Search Console تست کنید تا از صحت آن اطمینان حاصل کنید.

-

استفاده نادرست از Crawl-delay

استفاده نامناسب از دستور Crawl-delay میتواند به کاهش نرخ خزیدن و ایندکس گذاری سایت منجر شود.

User-agent:*

Crawl-delay: 120

راهکار:

فقط در صورت نیاز از Crawl-delay استفاده کنید و مقدار منطقی تنظیم کنید.

User-agent:*

Crawl-delay: 10

-

مسدود نکردن صفحات تکراری یا کم اهمیت

اشتباه:

عدم مسدود کردن صفحات تکراری یا کم اهمیت میتواند منجر به اتلاف منابع خزندهها و مشکلات محتوای تکراری شود.

راهکار:

مسیرهای صفحات تکراری یا کم اهمیت را به درستی مسدود کنید.

User-agent:*

Disallow: /duplicate-content/

بهطور کلی میتوان گفت این ربات ابزاری قدرتمند برای کنترل دسترسی رباتها به محتوای سایت است، اما اشتباهات در نوشتن این فایل میتواند تاثیرات منفی بر سئو و عملکرد سایت داشته باشد. با شناخت و اصلاح اشتباهات رایج، میتوانید اطمینان حاصل کنید که سایت شما به درستی ایندکس و بهینه سازی شده و دسترسی به بخشهای مهم سایت برای رباتها فراهم است.

تاثیر استفاده درست و نادرست از فایل های robots.txt بر سئو و عملکرد وبسایت

استفاده درست از فایل ربات میتواند به بهبود سئو و عملکرد وبسایت کمک شایانی کند. با استفاده صحیح از این فایل، مدیران وبسایت میتوانند دسترسی رباتهای موتورهای جستجو را به صفحات کم اهمیت یا حساس محدود کنند. این کار باعث میشود موتورهای جستجو بتوانند بر روی ایندکس گذاری محتوای ارزشمندتر تمرکز کنند که به بهبود رتبه سایت در نتایج جستجو منجر میشود. همچنین با جلوگیری از دسترسی رباتها به بخشهای غیرضروری میتوان بار سرور را کاهش داد که این امر به بهبود سرعت بارگذاری صفحات و افزایش تجربه کاربری منجر میشود.

در مقابل، استفاده نادرست از فایل robots.txt میتواند اثرات منفی بر سئو و عملکرد وبسایت داشته باشد. برای مثال، اگر بهطور اشتباهی دسترسی به صفحات مهم یا منابع ضروری مسدود شود، ممکن است موتورهای جستجو نتوانند محتوای سایت را به درستی ایندکس کنند. این امر میتواند منجر به کاهش رتبه سایت در نتایج جستجو و کاهش ترافیک ارگانیک شود.

همچنین مسدود کردن نادرست فایلهای CSS یا Javascript میتواند باعث اختلال در نمایش صحیح سایت و تجربه کاربری ضعیف شود؛ بنابراین تنظیم نادرست این فایل میتواند فرصتهای بهینه سازی را از بین ببرد و به عملکرد کلی سایت آسیب برساند. برای بهرهمندی کامل از مزایای این فایل مدیران وبسایت باید با دقت و دانش کافی این فایل را پیکربندی کنند تا از بروز مشکلات احتمالی جلوگیری کنند و به بهبود سئو و افزایش رتبه سایت خود کمک کنند.

راهنماییهای کاربردی برای بهینه سازی فایل ربات txt برای وبسایتها

بهینه سازی این فایل میتواند تاثیر قابل توجهی بر سئو و عملکرد کلی وبسایت داشته باشد. با علم به اینکه میدانیم robots.txt چیست، در اینجا چند راهنمایی کاربردی برای بهینه سازی این فایل آورده شده است:

-

مسدود کردن صفحات بیاهمیت یا حساس

یکی از اصلیترین کاربردهای فایل robots.txt جلوگیری از دسترسی رباتها به صفحات بیاهمیت یا حساس است. صفحات حاوی اطلاعات شخصی، دایرکتوریهای مدیریتی و صفحات موقت یا آزمایشی نباید توسط موتورهای جستجو ایندکس شوند.

User-agent: *

Disallow: /login/

Disallow: /admin/

Disallow: /temp/

-

جلوگیری از ایندکس شدن محتوای تکراری

برای جلوگیری از مشکلات محتوای تکراری که میتواند به سئو آسیب برساند، از فایل ربات برای مسدود کردن دسترسی به صفحات تکراری یا نسخههای مختلف یک صفحه استفاده کنید.

User-agent: *

Disallow: /duplicate-page/

-

اجازه دسترسی به منابع ضروری

برخی منابع مانند فایلهای CSS و Javascript برای درست نمایش داده شدن و عملکرد وبسایت ضروری هستند. مطمئن شوید که این منابع برای رباتها قابل دسترسی هستند.

User-agent:*

Allow: /css/

Allow: /js/

-

استفاده از Sitemap

افزودن آدرس نقشه سایت به فایل ربات txt میتواند به موتورهای جستجو کمک کند تا بهطور موثرتری صفحات سایت شما را ایندکس کنند. این کار باعث بهبود سئو و دسترسی به تمام بخشهای مهم سایت میشود.

Sitemap: http://www.example.com/sitemap.xml

-

تست و اعتبارسنجی robots.txt

قبل از اعمال تغییرات، حتما این ربات را با ابزارهای اعتبارسنجی مانند google search console بررسی کنید تا مطمئن شوید که دستورات به درستی اهمال میشوند و از مشکلات احتمالی جلوگیری میشود.

-

استفاده از دستور Crawl-delay

در صورتی که سرور شما با بار زیاد مواجه میشود، میتوانید از دستور Crawl-delay برای محدود کردن تعداد درخواستهای رباتها استفاده کنید. این دستور به رباتها میگوید که بین هر درخواست چند ثانیه صبر کنند.

User-agent: *

Crawl-delay: 10

-

تنظیمات خاص برای رباتهای مختلف

با در نظر گرفتن این نکات میتوانید بهینه سازی سئو، بهبود عملکرد سرور و مدیریت بهتری برای ایندکس محتواهای سایت خود داشته باشید. تنظیمات دقیق و بهینه این فایل میتواند تفاوت قابل توجهی در نحوه نمایش و عملکرد وبسایت شما در موتورهای جستجو ایجاد کند.

کلام پایانی

فایل robots.txt ابزاری قدرتمند و ضروری برای هر وبسایتی است که به مدیران آن امکان کنترل دسترسی رباتهای مورتوهای جستجو به صفحات سایت را میدهد. با تنظیم صحیح این فایل، میتوان از ایندکس شدن صفحات غیرضروری یا حساس جلوگیری کرد، بار سرور را کاهش داد و تجربه کاربری بهتری را فراهم کرد. در این مطلب به بررسی جامع robots.txt پرداختیم و توضیح دادیم که این فایل چیست، چه کاربردهایی دارد و چگونه باید نوشته شود. همچنین به اشتباهات رایج در نگارش این فایل و تاثیر استفاده صحیح و نادرست آن بر سئو و عملکرد سایت پرداختیم و راهنماییهای کاربردی برای بهینه سازی آن ارائه دادیم.

مدیریت دقیق فایل ربات txt میتواند به بهبود رتبه سایت در نتایج جستجو، افزایش کارایی سرور و جلوگیری از نمایش محتوای غیرضروری کمک کند. با رعایت نکات و راهنماییهای ارائه شده، مدیران سایت ها میتوانند اطمینان حاصل کنند که رباتهای موتورهای جستجو به درستی به محتوای سایت دسترسی دارند و بهترین نتایج ممکن برای بهینه سازی موتورهای جستجو به دست می آید.

با استفاده مناسب از فایل ربات میتوانید کنترل بیشتری بر نحوه نمایش و عملکرد سایت خود در موتورهای جستجو داشته باشید که این امر به بهبود کلی تجربه کاربری و افزایش بازدید سایت شما منجر خواهد شد. از این رو توصیه میکنیم که در نوشتن دستورات این فایل دقت لازم را داشته باشید و به صورت منظم آن را بررسی و بروزرسانی کنید تا به بهترین شکل ممکن از مزایای آن بهره مند شوید. در صورتی که در زمینه سئو و تنظیم فایل robots.txt تخصص کافی ندارید میتوانید از خدمات سئو سایت جینجر کمک بگیرید.

3 پاسخ

خیلی عالی بود. دست مریزاد

وقت بخیر دوست عزیز

نظر لطف شماست

به نظرم این ربات یکی از بخشهای مهم سئو میشه